Désinformation : structurer la recherche, organiser la défense

Deepfakes, infox, campagnes coordonnées sur les réseaux sociaux… Face à la montée en puissance des manipulations informationnelles, le CNRS, l’État-major des armées et le Campus Cyber, avec le soutien d’Inria, ont lancé une initiative inédite pour fédérer experts, scientifiques, industriels et acteurs de la société civile en vue d’outiller durablement la société française. Le cycle d’ateliers s’est clôturé le 25 juin dernier.

Un mouchoir posé sur une table devant le président. Une vidéo d’une journaliste coupée au mauvais moment. Rien de truqué. Et pourtant, tout est biaisé. Les campagnes de manipulation opèrent désormais à fronts renversés : elles exploitent le vrai pour mieux semer le doute. L’objectif ? Fracturer les opinions, miner la confiance ou encore polariser la société. Si bien qu’en 2024, le Forum économique mondial a placé la désinformation et la mésinformation1 au premier rang des risques mondiaux, devançant même le défi climatique.

Face à cette menace croissante, le CNRS, l’État-major des armées et le Campus Cyber2 , avec le soutien d’Inria, ont lancé à l’automne 2024 un cycle d’ateliers inter- et pluridisciplinaires3 pour en décrypter les mécanismes, identifier les angles morts scientifiques et techniques, bâtir la résilience collective et renforcer la collaboration entre les acteurs. Ce travail, achevé fin juin 2025, constitue une première étape pour bâtir un écosystème de confiance décloisonné mobilisant acteurs académiques, institutionnels, industriels mais aussi de la société civile autour de la lutte contre les manipulations de l’information.

« La maîtrise de l’environnement informationnel est aujourd’hui essentielle à la cohésion nationale », affirme le général Jean-Michel Meunier, chef de la cellule Anticipation stratégique et orientation de l’État-major des armées, qui a participé aux ateliers. Telle une pandémie, la manipulation de l’information se propage à grande vitesse grâce aux réseaux sociaux et à l’IA générative. Au cœur du système : des plateformes qui ont leurs propres intérêts. « Elles ont bâti leur empire sur l’économie de l’attention, nourrie d’algorithmes qui privilégient des contenus à fort impact qui jouent souvent sur les émotions, qui induisent à leur tour la division », pointe Anne-Laure Thomas Derepas, responsable des partenariats et de la valorisation de l’Institut des systèmes complexes de Paris Île-de-France (CNRS). Il est essentiel de comprendre les mécanismes qui rendent possible cette pandémie et anticiper ses conséquences sur les personnes et la société.

Et dans notre monde où chacun devient relais d’information, l’impact est systémique. « In fine, on en revient toujours à une question centrale : à quoi puis-je faire confiance ? », interroge Nicolas Porquet, responsable de la coopération avec la filière cybersécurité au CNRS. De la défense nationale aux citoyens, tout le monde est concerné. Et la France, comme d’autres démocraties, reste insuffisamment préparée à ce fléau du XXIe siècle.

- 1La désinformation survient quand une personne diffuse intentionnellement une information fausse. Dans le cadre de la mésinformation, au contraire, une personne diffuse une information fausse en pensant qu’elle est vraie.

- 2Lieu totem de la cybersécurité qui rassemble à La Défense les principaux acteurs nationaux et internationaux du domaine.

- 3Porquet, N. (2025). « Fédérer un écosystème de confiance en matière de lutte contre la manipulation de l’information ». Revue Défense Nationale, 876(1), 82-88.

Premiers jalons d’une réponse collective

Comment génère-t-on une information manipulée ? Qu’est-ce qui la rend virale ? Comment y répondre sans l’amplifier ? Et comment préparer la société à y résister ? C’est autour de ces quatre questions que s’est structuré le cycle d’ateliers. « Jusqu’à présent, les actions sur le sujet restaient cantonnées à certains écosystèmes restreints : académiques, institutionnels, industriels ou associatifs. Là, on a réussi à créer un trait d’union entre ces différents écosystèmes et au-delà, avec 250 experts mobilisés sur la durée pour l’intérêt général », souligne Nicolas Porquet.

À chaque rencontre : une centaine de participants — scientifiques, militaires, industriels, associations, journalistes et représentants des services de l’État — réunis pour réfléchir ensemble et partager autour d’un sujet hautement inflammable. Contributrice du groupe de travail sur la propagation et la viralité, l’entreprise de services numériques Sopra Steria s’est impliquée, aux côtés d’autres acteurs industriels, pour renforcer les ponts entre le monde académique et les entreprises. « Nous avions déjà créé un forum de confiance, regroupant des représentants des mondes politique, académique, médiatique, économique et étatique (le cercle Pégase), et les ateliers nous ont ouvert à la recherche qui était jusque-là peu présente dans notre écosystème. Cela nous évite de dupliquer des actions identiques et donc nous permet d’avancer plus vite ensemble », témoigne le général Bruno Courtois, conseiller Défense chez Sopra Steria.

Pour les armées, cette collaboration est un tremplin vers de futures solutions. « Sur les technologies émergentes, la recherche peut nous aider à caractériser les menaces — comme elle le fait déjà sur les IA ou les biotechnologies », observe le général Meunier. Finalement, ces ateliers ont apporté un premier état des lieux des défis actuels et à venir. Mais aussi les fondations d’un champ scientifique encore jeune. « Il faut développer, structurer et soutenir une recherche fondamentale pluridisciplinaire de haut niveau qui viendra nourrir l’innovation. Le développement d’outils nécessite non seulement de comprendre les menaces actuelles, mais aussi de développer une expertise académique permettant de répondre aux défis futurs sur le plan informationnel », martèle Nicolas Porquet.

Comprendre pour mieux agir

« Nos connaissances sur les manipulations de l’information sont encore balbutiantes, comme la cybersécurité il y a dix ans. Aujourd’hui nous devons anticiper et nous organiser », observe Bruno Courtois. Et pendant que nous essayons de la comprendre, la menace évolue. Plus ciblées, plus subtiles, les attaques sont souvent indétectables à l’œil nu. Les IA génératives produisent à grande échelle des contenus trompeurs, mais plausibles. Nicolas Porquet complète : « Il faut créer un environnement propice à une information fiable tout en garantissant la liberté d'expression ».

L’exemple de l’opération DoppelGänger, une vaste campagne de désinformation pro-russe active depuis 2022, illustre bien ces enjeux. Menée dans le contexte de l’invasion de l’Ukraine, elle vise à saper le soutien occidental à Kiev en inondant les réseaux d’articles truqués et de fausses informations. Sites clonés, contenus falsifiés, IA générative : tout est mobilisé pour usurper l’identité de médias reconnus — de 20 Minutes à The Guardian — et diffuser des narratifs mensongers à grande échelle. Cette campagne ne pourrait tout simplement pas exister sans cette infrastructure technologique sophistiquée. Elle montre à quel point les canaux de communication modernes sont devenus l’épine dorsale des stratégies de manipulation.

Une réponse interdisciplinaire

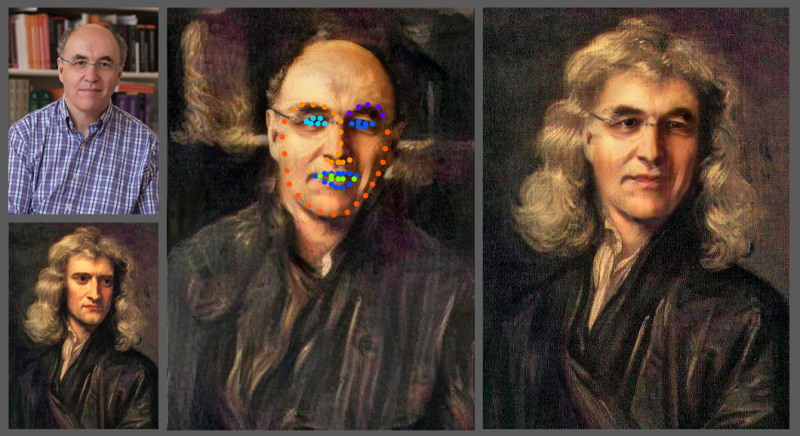

Pour comprendre les mécanismes viraux d’une campagne, il faut modéliser, analyser des masses de données et détecter des signaux faibles. Pour évaluer une menace juridique, croiser droit et philosophie politique. Et pour construire des outils fiables, identifier l’origine des informations (comme le propose le watermarking1 ), développer des IA explicables et renforcer la cybersécurité. Le projet Compromis du Programme et équipements prioritaire de recherche (PEPR) Cybersécurité vise justement à répondre aux enjeux de protection des données multimédia en détectant notamment les contenus générés par IA et les deepfakes (ou hypertrucages).

- 1 aucun consensus scientifique n’existe sur sa fiabilité ou sa mise en œuvre à grande échelle.

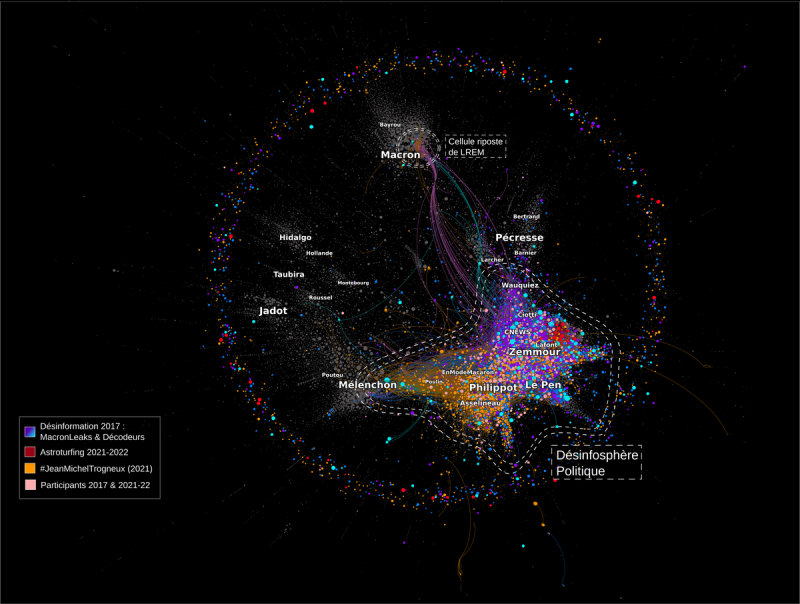

« Cependant, des outils numériques de détection ne suffiront pas. Les biais cognitifs1 sont également une vraie porte d’entrée à étudier », explique Anne-Laure Thomas Derepas. C’est ce qu’illustre, par exemple, le biais d’influence continue : une fausse information, même rectifiée par la suite, continue à influencer nos raisonnements. Ce phénomène impose une réaction rapide, ciblée — mais sans amplification involontaire. En ce sens, les scientifiques du cycle ont notamment étudié des méthodes de détection d’attaques coordonnées, comme des arbres de propagation construits à partir de signaux faibles. Mais souvent, le temps d’identifier la source, l’information s’est déjà répandue. La réponse est encore à contretemps.

« La désinformation est avant tout une action humaine, organisée par des individus ou des groupes, dans un but social ou politique, rappelle Marie Gaille, directrice de CNRS Sciences humaines & sociales, l’un des dix instituts du CNRS. Elle s’inscrit dans un écosystème informationnel profondément dégradé, qui fragilise la cohésion des sociétés et la qualité du débat démocratique. Par définition, c’est un objet central pour les sciences humaines et sociales ». En effet, les concepts d’opinion, d’information, de croyance doivent être repensés à l’aune des réseaux sociaux et de l’IA. L’éthique pourrait aider à tracer le cadre des contre-mesures possibles en démocratie.

Une approche holistique

« L’information devrait être un bien commun dans nos démocraties. On a besoin des outils d’analyse numérique pour modéliser les mécanismes de propagation, les détecter et les contrer. Les équipes de recherche sont mobilisées sur le sujet mais l’algorithmique ne fait pas une stratégie », alerte Adeline Nazarenko, directrice de CNRS Sciences informatiques. La lutte contre la manipulation de l’information doit être appréhendée de manière holistique intégrant différents regards disciplinaires, au croisement des enjeux civils et militaires, en associant les mondes de la recherche, de la sécurité et du journalisme.

- 1Il s’agit de mécanismes mentaux qui influencent notre façon de percevoir, de juger ou de nous souvenir — souvent sans qu’on en ait conscience et qui peuvent nous induire en erreur.

En ce sens, le CNRS joue un rôle central par sa capacité à croiser les approches scientifiques. « C’est en mobilisant tout un ensemble de compétences notamment en sciences humaines et sociales et avec les sciences de l’informatique, que l’on peut espérer analyser le phénomène et ses enjeux et identifier des leviers d’action efficaces », poursuit Marie Gaille. Le projet Européen AI4Trust impliquant plusieurs unités CNRS1 est une belle illustration de cette approche pluridisciplinaire et européenne. Ce projet vise à renforcer la réponse humaine pour lutter contre la désinformation dans l'Union européenne en dotant les chercheurs et les professionnels des médias de technologies avancées basées sur l'IA.

D’autres projets structurants existent à l’image d’Hybrinfox2 , mêlant sciences humaines et sociales et sciences informatiques et qui a une double visée scientifique et industrielle. Il prend pour levier principal l’identification d’informations vagues, susceptibles d’introduire ou de favoriser des biais, ainsi que la polarisation en ligne, la vérification de l’information ou encore la radicalisation. Mais il reste un enjeu de taille : structurer cette communauté scientifique encore jeune, lui donner les moyens d’agir… et surtout continuer de la faire dialoguer avec la société.

De la connaissance à l’action

Dans un environnement où la confiance s’effrite et où le vrai se confond au faux, « cette mobilisation scientifique n’est pas un luxe, mais une nécessité démocratique », insiste Nicolas Porquet. La meilleure défense ne reposera toutefois pas uniquement sur des algorithmes ou des lois, mais sur une société préparée : citoyens, enseignants, journalistes capables de repérer, comprendre, expliquer, démystifier et se prémunir.

- 1Le centre Marc Bloch (BMBF/CNRS/Ministère de l’Europe et des Affaires étrangères/Ministère de l’Enseignement supérieur et de la Recherche), le Centre de recherche en économie et statistique (CNRS/École polytechnique/Genes) et le Centre de sociologie des organisations (CNRS/Sciences Po Paris).

- 2Mené conjointement par l’Institut Jean-Nicod (CNRS/ENS – PSL/EHESS) et l’Irisa.CNRS/ Université de Rennes/Centrale Supelec/ENS Rennes/Inria/IMT Atlantique Bretagne-Pays de la Loire/INSA Rennes/Université de Bretagne-Sud).

Traduire les savoirs en réponses concrètes sera ainsi l’un des enjeux majeurs des suites du cycle d’ateliers. « Nous sommes une institution de l’action ; tout cela ne vaut que si cela nous permet d’agir dans le monde réel et notamment de prendre le dessus sur nos adversaires », souligne le général Jean-Michel Meunier. Les travaux sur les réseaux sociaux, par exemple, ont déjà des implications concrètes pour contrer certaines campagnes.

Si le cycle achevé en juin a permis de jeter les bases d’un écosystème multi-acteur, révélant l’ampleur des défis et la nécessité d’une recherche renforcée, une approche cohérente et partagée sera clé pour renforcer la résilience collective. En ce sens, l’appel à projet ASTRID1 « Résistance » – lancé en juin dernier par l’Agence nationale de la recherche et l’Agence de l’innovation de défense – constitue une première opportunité de capitaliser sur cet élan et de mobiliser la recherche académique sur la question de la résistance des citoyens aux manipulations de l’information.

- 1Accompagnement spécifique des travaux de recherches et d’innovation Défense.